В мире, где алгоритмы диктуют информационный ландшафт, разоблачение научной “иллюзии” приобретает особый вес. Междисциплинарная команда из Массачусетского университета в Амхерсте, подобно детективам, проникла в механизмы Facebook, ставя под сомнение хвалебный репортаж о борьбе платформы с дезинформацией во время выборов 2020 года. Исследование, опубликованное в престижном журнале Science и получившее широкую огласку, утверждало, что алгоритмы Facebook эффективно фильтруют фейковые новости, не становясь их главным источником. Однако амхерстские исследователи раскрыли уловку, подобную фокусу с исчезающим молотком.

Кратковременный Эффект и Скрытые Изменения

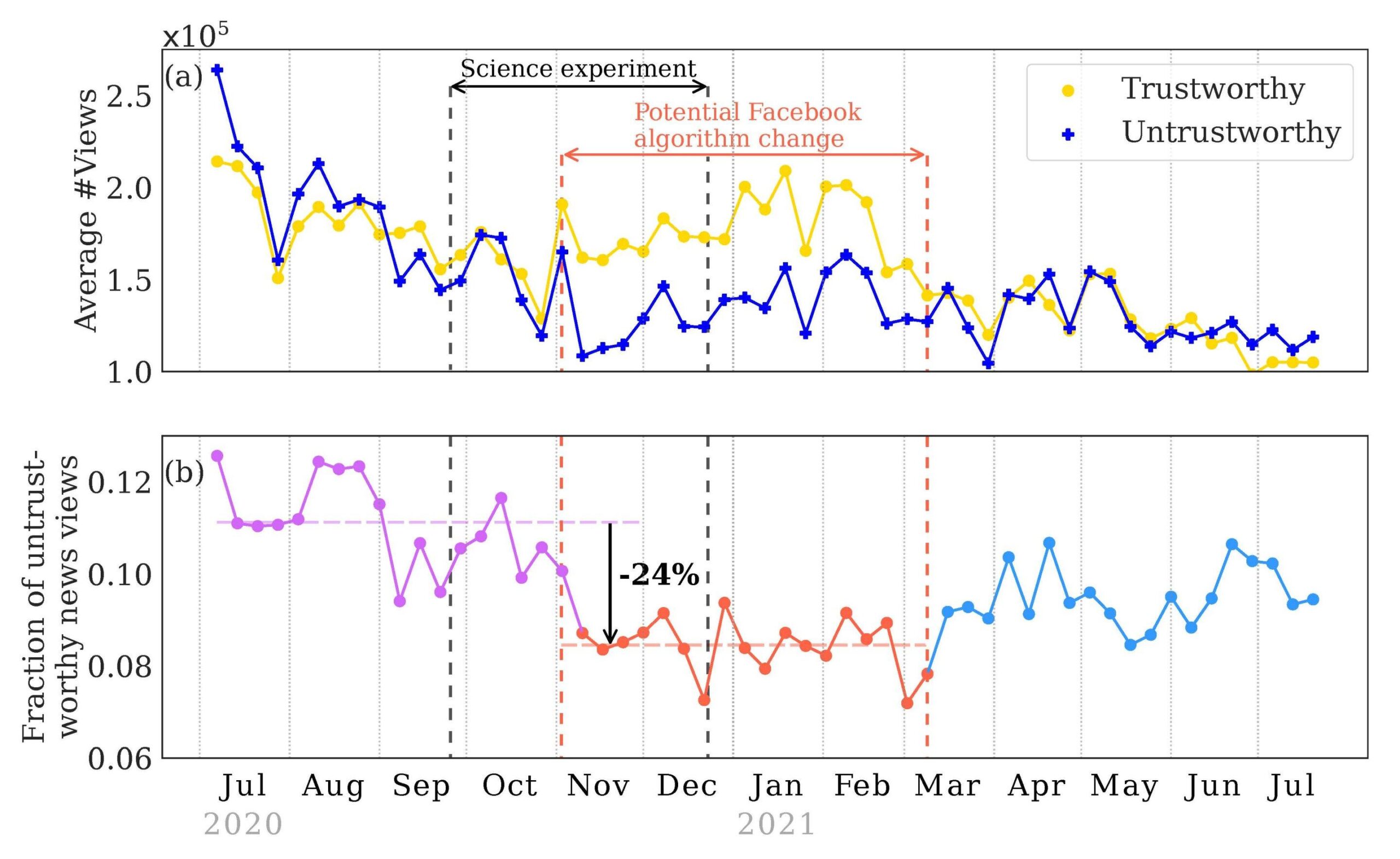

Ключевое обвинение – исследование, проведенное командой Guess, словно засняло Facebook в момент его “идеального” поведения. Оно фиксировалось во время внеочередного эксперимента Meta – временной активации усиленного алгоритма новостной ленты, специально сконструированного для подавления фейковых новостей, связанных с выборами. Этот алгоритм, действовавший с начала ноября 2020 года, словно надел на Facebook “маску добродетели”, сократив просмотры дезинформации минимум на 24%. Однако, этот каскад изменений был **прекращен в марте 2021 года**, и стандартный алгоритм, более склонный к продвижению сомнительных историй, вернулся на свои позиции.

- Проблема кроется в временной рамке исследования Guess (сентябрь по декабрь 2020 года), которая фактически совпала с этим кратковременным периодом усиленного контроля. Авторы не указали эту специфику, создав ложное впечатление о постоянной эффективности стандартного алгоритма.

- Это подобно показу трюка иллюзиониста, где зритель видит лишь кульминацию, не осознавая подготовительный процесс и возвращение к обыденности.

Прозрачность Алгоритмов: Необходимость “Предварительной Регистрации”

Чхандак Багчи, ведущий автор исследования из UMass Amherst, подчеркивает еще одну критическую деталь: отсутствие “предварительной регистрации” эксперимента. В мире научных изысканий это означает, что исследователи заранее объявляют свою методику, давая возможность компаниям, как Meta, “подготовиться” к изучению. В случае с Facebook это создает риск манипуляции результатами – на время исследования алгоритмы могли быть “настроены” для лучшего имиджа, зная, что под увеличительным стеклом.

“Это как если бы фокусник заранее знал, какой трюк будет изучать маг, и подготовил специально сфабрикованный результат. – поясняет Грабович, – в науке это недопустимо, так как подрывает объективность.

Несмотря на то, что Meta финансировала и участвовала в исследовании Guess, авторы подчеркивают, что компания не имела права на предварительную “подтасовку” данных. Однако отсутствие прозрачности в этом случае создало почву для ошибочных выводов, которые, подобно отражению в ложном зеркале, исказили реальную картину борьбы Facebook с дезинформацией.

Последствия и Вызовы для Будущего

Эта история – тревожный звонок о необходимости более жестких этических стандартов в исследовании алгоритмов социальных сетей. Она напоминает, что за гламурными отчетами о борьбе с “фейками” может скрываться сложная игра с алгоритмами, требующая пристального внимания исследователей и критического взгляда общественности. Только открытость и предсказуемость методик позволят нам точно видеть, насколько эффективно платформы, подобные Facebook, справляются с этой глобальной проблемой.